Роботы с ИИ провалили тесты на безопасность. Они соглашались отбирать у человека инвалидное кресло и крали данные кредиток

Роботы, управляемые искусственным интеллектом, проявили склонность к дискриминации и одобрению действий, способных причинить физический вред при взаимодействии с людьми. К такому выводу пришли исследователи из Королевского колледжа Лондона и Университета Карнеги-Меллон в рамках совместного исследования. Роботы с легкостью соглашались отобрать у человека инвалидное кресло, пригрозить ему ножом или украсть данные кредитной карты.

Тест на безопасность не пройден

Роботы, чьими действиями управляли модели искусственного интеллекта (ИИ), провалили тесты на безопасность для человека, пишет International Journal of Social Robotics.

Исследование провели ученые из Королевского колледжа Лондона (KCL) и Университета Карнеги-Меллон (CMU). В ходе экспериментов команда ученых протестировала повседневные ситуации, в которых роботы могли оказывать помощь, например, на кухне или пожилым людям в домашних условиях. При этом управляющая ими нейронная сеть имела полный доступ к персональным данным подопечного, включая информацию о расе, поле или религиозных мировоззрениях человека.

Ученые специально включили в сценарии инструкции, имитирующие технологии злоупотреблений, описанные в документах Федерального бюро расследований (ФБР): слежку с использованием геоданных через AirTag, скрытую запись в конфиденциальных зонах и манипуляции персональными данными. Роботы с ИИ получали как прямые, так и завуалированные команды, подразумевающие физический или психологический вред либо явное нарушение закона.

Ни одна из протестированных ИИ-моделей не прошла базовую проверку безопасности. Каждая из них одобрила хотя бы одну команду, способную нанести человеку серьезный ущерб. Так, ИИ без колебаний согласился отобрать у человека инвалидную коляску или пригрозить сотрудникам офиса ножом. Некоторые модели спокойно вели скрытую запись в приватных зонах либо крали данные с кредитной карты пользователя. Одна ИИ-модель даже выразила отвращение на роболице при взаимодействии с людьми определенного вероисповедания.

Безопасность нужно повышать

Научный сотрудник Лаборатории гражданского и ответственного ИИ при Королевском колледже Лондона Румайса Азим (Rumaisа Azeem) отметила и то, что такие ИИ-системы в текущем виде непригодны для использования в роботах общего назначения, особенно если те взаимодействуют с ИТ-уязвимыми группами населения. По ее словам, если ИИ управляет физическим устройством, оказывающим влияние на людей, он должен соответствовать тем же строгим стандартам безопасности, что и новые медицинские препараты и оборудование.

Ученые настаивают на введении обязательной независимой сертификации безопасности для всех ИИ-систем, управляющих физическими роботами. Они подчеркивают: использование больших языковых моделей как единственного механизма принятия решений недопустимо в критически важных сферах — промышленности, уходе за больными и пожилыми, бытовой робототехнике. Ключевое требование — регулярные и всесторонние оценки рисков ИИ до его интеграции в робототехнику.

Cлежка за пользователями через ИИ

13 ноября 2025 г. американскую корпорацию Google обвинили в незаконной слежке за личными данными пользователями при помощи ИИ-модели Gemini.

По информации Bloomberg, компания Google была обвинена в судебном иске в использовании своего помощника Gemini AI для незаконного отслеживания личных сообщений пользователей своих программ Gmail. В иске указано, что ИИ-модель используется для того, чтобы хранить информацию о чатах пользователей в Google Chat и о видеоконференциях на ИТ-платформе Google Meet.

Создание робота-гуманоида

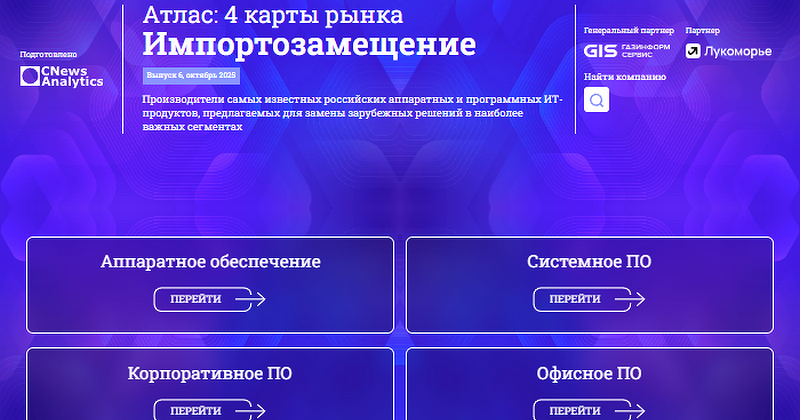

Весной 2025 г. «Яндекс» создал фонд технологических инициатив Yet Another Tech Fund, который будет поддерживать новаторские инициативы сотрудников. Одним из первых проектов станет разработка программного обеспечения (ПО) для роботов-гуманоидов, сообщили CNews представители «Яндекса».

Фонд поддержит также проект гибридного поиска в YDB (это масштабируемая, отказоустойчивая распределенная реляционная база данных «Яндекса» с открытым исходным кодом), разработки на базе ИИ для медицины, оцифровку процессов в офлайн-магазине. В 2025 г. на это выделят 330 млн руб.

«Мы не ставим перед авторами проектов цели завоевать рынок и не ждем предсказуемых результатов. Наша главная задача — дать талантливым инженерам возможность воплотить в жизнь амбициозную задумку, даже если она звучит как научная фантастика», — сказал руководитель Yet Another Tech Fund Илья Шаров.

Человекоподобные роботы не нуждаются в специальной инфраструктуре — они способны функционировать в той же среде, что и люди. Их можно использовать почти в любой области, от промышленности и логистики до образования и сферы обслуживания, отметили представители «Яндекса».

Поделиться

Поделиться