Программисты, за которых работают нейросети, пишут в 3-4 раза больше кода, но создают в 10 раз больше проблем безопасности

Применение ИИ-ассистентов помогает программистам писать код быстрее в три-четыре раза, но также ведет к закладыванию в него трудноустранимых проблем безопасности, которые в сгенерированном коде встречаются на порядок чаще, чем в том, что написан разработчиками вручную. По оценке специалиста компании Apiiro, «ИИ исправляет опечатки, но создает бомбы с часовым механизмом»Помощник или вредитель?

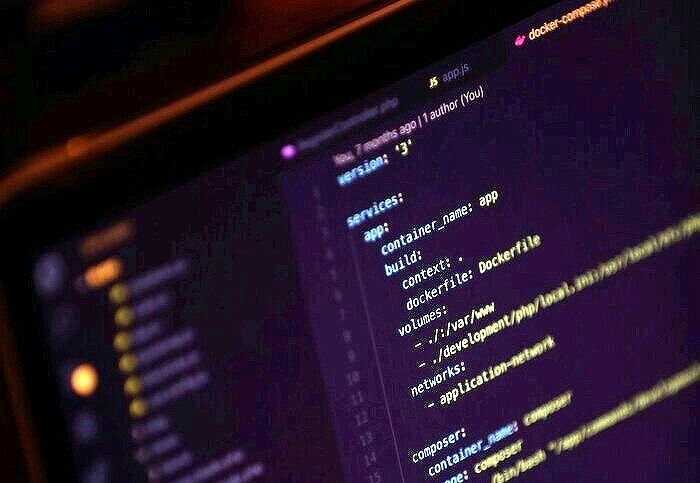

Компания Apiiro, разработчик ПО для анализа безопасности приложений, проанализировала огромный массив программного кода, полученного из открытых источников, чтобы сформировать более полное представление о том, какое влияние на конечный результат оказывают ИИ-инструменты вроде Claude Code компании Anthropic, GPT-5 от OpenAI и Gemini 2.5 Pro корпорации Google.

В общей сложности было обработано несколько десятков тысяч репозиториев, содержащих код, написанный тысячами разработчиков, которые имеют связи с компаниями из списка Fortune 50, пишет The register.

В результате выяснилось, что обращающиеся к услугам ИИ-ассистентов программисты демонстрируют значительно более высокую продуктивность в сравнении со своими консервативными коллегами: первые пишут в три-четыре раза больше кода, чем последние. При этом проблемы безопасности в коде первых встречаются в 10 раз чаще.

Под «проблемами безопасности» в Apiiro подразумевают не обязательно непосредственно эксплуатируемые уязвимости, а скорее применение практик, несущих риски возникновения ошибок и появления брешей в ПО. Среди них, в частности, использование открытого кода в качестве зависимостей, использование небезопасных паттернов и хранение секретов (например, ключей API) в коде.

ИИ плодит проблемы безопасности

Согласно подсчетам Apiiro, количество проблем такого рода в коде проанализированных репозиториев выросло в июне 2025 г. десятикратно к декабрю 2024 г.

«ИИ плодит не один конкретный вид уязвимостей, а все сразу», – написал в блоге компании менеджер по продукции Apiiro Итай Нуссбаум (Itay Nussbaum), – «…Посыл для гендиректоров и советов директоров предельно простой: если вводите обязательное применение ИИ при написании кода, необходимо параллельно вводить и обязательное использовании ИИ-AppSec. Иначе вы просто способствуете росту рисков в том же темпе, что и росту производительности».

Специалисты компании также выяснили, что ИИ-помощники программиста, сгенерировавшие код, которым впоследствии попал в датасет Apiiro, имели склонность к формированию больших по объему пул реквестов (запросов на включение нового кода в репозиторий; – прим. CNews) в меньших количествах. Такой подход затрудняет проверку кода перед его включением в проект.

Исправляет отпечатки, но закладывает бомбы с часовым механизмом

Говоря об ИИ-помощниках программиста, нельзя не отметить и их достоинства. По оценке Apiiro, их применение при написании кода позволяет добиться снижения количества ошибок: синтаксических – на 76%, логических – на 60%. Однако за удобство приходится расплачиваться повышенными рисками получить некачественный или небезопасный код. В сгенерированных ИИ программах на 153% чаще встречаются архитектурные изъяны, и на 322% – способные обернуться уязвимостью, ведущей к повышению привилегий, в будущем.

«Другими словами, ИИ исправляет опечатки, но создает бомбы с часовым механизмом», – отмечает Нуссбаум.

Анализ, проведенный Apiiro, также показал, что разработчики, полагающиеся на ИИ-помощников, вдвое чаще допускают хранение конфиденциальных данных для доступа к облачным сервисам в открытом виде, нежели программисты, предпочитающие ручной труд.

Другие исследования

Как отмечает The Register, выводы Apiiro перекликаются с работами других исследовательских групп. Так, в мае 2025 г. специалисты из Университета Сан-Франциско (Калифорния, США), Векторный институт (Канада) и Массачусетский университет в Бостоне (Массачусетс, США) опубликовали препринт работы, в рамах которой установили, что использование ИИ-моделей для итеративного улучшения образцов программного кода способствует снижению его безопасности. Вывод неудивительный, поскольку модели, лежащие в основе ИИ-помощников, обучаются на огромных массивах кода, написанного человеком, и таким образом «впитывают» как его достоинства, так и недостатки.

В то же время результаты исследования Apiiro противоречат выводам независимой аналитической команды METR. Как ранее сообщил CNews, проведенное METR рандомизированное контролируемое исследование показало, что ИИ-программисты снижают производительность своих живых коллег, притом в среднем на 19%.

Поделиться

Поделиться