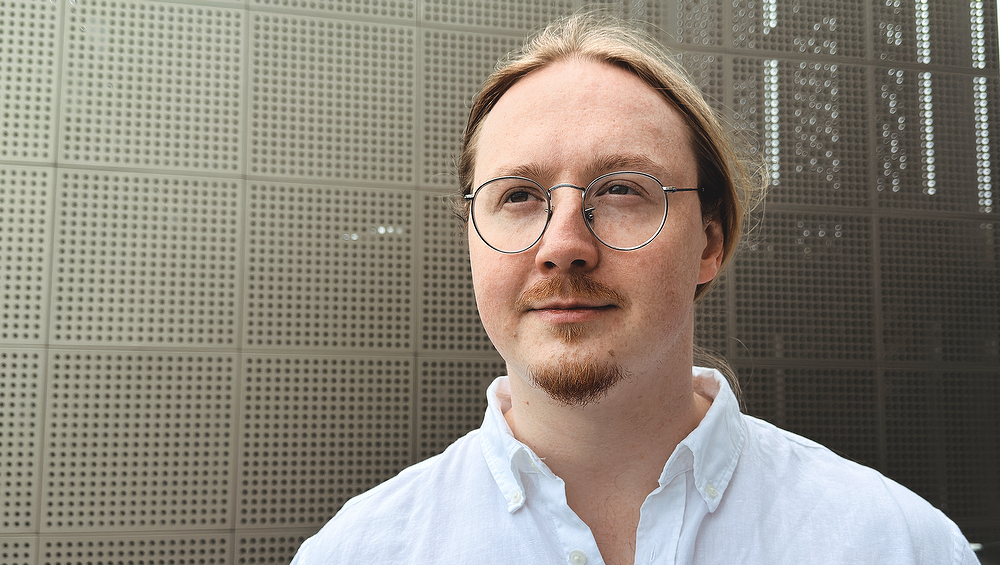

Томас Хелльстром, IDT Corp.: Хаос-эксперименты подсвечивают уязвимости, которые уже нельзя заметить другим способом

В 2025 году рынок инструментов для chaos engineering оценивается уже в 2,15 миллиарда долларов, и эксперты прогнозируют его рост до 3,1 миллиарда к 2029 году. Больше всего такие практики нужны там, где сбои недопустимы: в финтехе и авиации, где доступность систем должна держаться на уровне 99,9%. Томас Хелльстром, старший инженер-программист в IDT Corp., доказывает ценность этого подхода на практике: с помощью chaos engineering он помог запустить приложение для обмена авиабилетов всего за два месяца во время пандемии, избежав сбоев при резком росте нагрузки. CNews поговорил с Томасом, чтобы выяснить, почему преднамеренно разрушать системы не только можно, но и нужно для их надежности и масштабируемости.

CNews: Томас, расскажите, что такое chaos engineering и зачем он нужен? Почему традиционные подходы к тестированию не покрывают эти сценарии?

Томас Хелльстром: Традиционные тесты — юнит, интеграционные, end-to-end — проверяют систему в «идеальном мире»: все сервисы доступны, сеть стабильна, база данных отвечает мгновенно.

Но в реальной жизни всё иначе — сервер может упасть, сеть может «просесть», а кто-то случайно выкатывает не тот билд.

Chaos engineering как раз моделирует эти ситуации. Мы специально создаём сбои: отключаем часть серверов, замедляем базу, рвём соединение между датацентрами — и смотрим, что произойдёт.

Главная цель — не просто проверить, «работает ли логика», а понять, как именно система ломается:

- предсказуемо ли она себя ведёт;

- изолируются ли ошибки или тянут за собой всё приложение;

- насколько быстро идёт восстановление;

- срабатывают ли алерты (уведомления о сбоях);

- и успевает ли команда отреагировать по инструкции.

По сути, chaos engineering учит систему и людей быть готовыми к неожиданностям — прежде чем они произойдут в продакшене.

CNews: Какие инструменты и фреймворки существуют для тестирования отказоустойчивости? В чем различия между Chaos Monkey, Gremlin, Litmus, Pumba?

Томас Хелльстром: Я бы начал вообще без фреймворков. На старте достаточно простых скриптов, которые замедляют сеть, эмулируют сбои интеграций. Главное — делать это контролируемо: сначала в тестовом окружении, потом постепенно пробовать в реальном, например в часы низкой активности пользователей.

Когда система растёт, подключаются готовые инструменты:

- Chaos Monkey (Netflix)

Простой, но показательный инструмент. Он случайным образом выключает узлы (серверы) и заставляет архитектуру быть устойчивой к внезапным сбоям. - Pumba

Лёгкий инструмент для Docker. Позволяет симулировать сетевые проблемы — потери пакетов, задержки, нестабильное соединение. Удобен, когда нужно проверить поведение контейнеров в «грязной» сети. - Litmus

Open-source-решение для Kubernetes. Поддерживает подход chaos as code — сценарии описываются как YAML-манифесты, можно встроить хаос-тесты прямо в CI/CD-конвейер. Это удобно для команд, которые хотят автоматизировать проверки в облачной среде. - Gremlin

Коммерческая платформа с десятками видов «атак»: от отключения CPU до симуляции сбоев DNS. Есть визуальный интерфейс, аналитика и поддержка — хорошее решение для крупных компаний, где важно масштабирование и контроль.

CNews: Ваша карьера началась в стартапах, а затем привела к крупным проектам. Как опыт работы в разных масштабах сформировал ваше понимание ценности chaos engineering?

Томас Хелльстром: В стартапах и на этапе прототипа хаос-эксперименты почти не нужны. Система маленькая, всё быстро меняется, и сбои можно отследить вручную.

Но когда продукт выходит на рынок, всё усложняется: растёт нагрузка, появляется десятки интеграций, команды работают параллельно — и каждая минута простоя уже стоит денег.

Вот здесь chaos engineering и показывает свою силу. Он помогает не просто «проверить стабильность», а доказать, что система выдержит удар.

Есть и вторая сторона — знание структуры.

Когда кодовая база небольшая, команда держит её в голове. Но с ростом проекта теряется полная картина: сложно понять, где слабое звено. Chaos engineering компенсирует этот пробел — он подсвечивает уязвимости, которые уже невозможно заметить вручную.

CNews: Как обосновать затраты на chaos engineering для руководства? Какие аргументы наиболее убедительны?

Томас Хелльстром: Самый сильный аргумент — реальные сбои. Стоит вспомнить недавний инцидент — свой или из индустрии: сколько стоил простой, сколько клиентов ушло, как упали продажи или рейтинг в App Store.

Например, в одной финтех-компании обновили микросервис платежей, и всё прошло «успешно» — пока через неделю не случился сбой в стороннем API. Из-за этого на два часа зависла обработка переводов. Команда узнала об инциденте только после шквала жалоб в поддержку.

Потери — около 8 миллионов рублей, не считая репутационных. Chaos engineering мог бы выявить это заранее: достаточно было провести эксперимент с отключением внешнего API и проверить, как система реагирует на тайм-ауты и повторные запросы.

Второй аргумент — опыт лидеров рынка. Netflix, Amazon, Google, Microsoft давно используют хаос-эксперименты, чтобы подтверждать свои SLA и снижать риск простоев.

И важно подчеркнуть: речь не о миллионах вложений. Начать можно с малого — нескольких простых сценариев, которые дадут наглядный результат и уверенность команде.

CNews: Во время пандемии вы вывели на рынок приложение для обмена билетов за два месяца, сгенерировавшее многомиллионный оборот. Как chaos-тесты могли бы обезопасить такой быстрый запуск?

Томас Хелльстром: Пандемия сильно ударила по авиаперевозкам, и за считанные недели мы разработали систему, которая позволяла менять билеты на ваучеры. Команды работали параллельно, интеграции частично заменили моками — важно было успеть. Мы провели весь стандартный набор тестов: интеграционные, E2E, нагрузочные.

Но chaos engineering позволил бы заметить то, что обычные тесты не показали — цепную реакцию сбоев при медленных ответах от внешнего сервиса бронирования. В результате успешные бронирования не фиксировались, а пользователи видели ошибку.

После анализа мы перевели запросы из синхронной модели в асинхронную — и тем самым сняли риск массовых отказов.

Фактически, chaos-тесты помогли бы обнаружить слабое звено заранее, до выхода на рынок, и избежать проблем, которые в условиях высокой нагрузки могли стоить миллионы.

CNews: Вы сократили расходы на 60% за счет миграции на AWS ECS и внедрения Terraform. Как chaos engineering дополняет такие практики для повышения надежности и масштабируемости?

Томас Хелльстром: Верно, мы перенесли инфраструктуру в AWS ECS — это сервис, который позволяет запускать и управлять контейнерами без необходимости держать собственные серверы. Проще говоря, он автоматизирует развертывание и управление приложениями, снижая затраты на обслуживание.

Вместе с Terraform, который описывает инфраструктуру «как код», это дало нам гибкость и прозрачность: окружения создаются и восстанавливаются в несколько команд.

Но экономия сама по себе не гарантирует устойчивость. Chaos engineering проверяет, перезапускаются ли контейнеры при сбое, восстанавливает ли Terraform окружение после сбоев, не ломает ли авто-масштабирование бизнес-логику приложения.

Такие эксперименты подтверждают, что система готова к реальной нагрузке и неожиданным инцидентам, а не только к красивым графикам в отчётах.

CNews: В микросервисах часто случаются «цепные аварии», когда падает один сервис и за ним тянутся остальные. Как chaos engineering предотвращает их, особенно в финтехе или авиации?

Томас Хелльстром: В распределённых системах эффект домино очень заметен: падает один сервис — и за ним «ложатся» остальные. Chaos engineering помогает вовремя разрывать цепочку. Эксперименты искусственно создают задержки, ошибки или отказ сервисов, чтобы проверить, насколько корректно срабатывают механизмы защиты — таймауты, circuit breaker, повторные запросы и fallback-обработка.

В финтехе это критично: если антифрод-сервис зависнет, нельзя допустить блокировку всех платежей. Если один провайдер недоступен — система должна переключиться на другого.

В авиаперевозках аналогично: задержка в бронировании не должна парализовать весь поток. Chaos engineering помогает выявить, где нужны дополнительные предохранители, и убедиться, что система остаётся работоспособной даже при неожиданных сбоях.

CNews: Какие паттерны отказоустойчивости — Circuit Breaker, Retry, Bulkhead, Timeout — наиболее важны, и как chaos engineering помогает их валидировать?

Томас Хелльстром: Всё зависит от контекста, но есть базовые «защитные механизмы» для микросервисов:

- Timeout — ограничивает время ожидания ответа от сервиса, чтобы один медленный запрос не блокировал всю систему.

- Circuit Breaker — «выключает» проблемный сервис при повторных сбоях, чтобы не проваливалась цепочка зависимостей.

- Retry — повторная попытка запроса при кратковременных ошибках. Работает только вместе с таймаутом, иначе может усугубить проблемы.

- Bulkhead — разделение ресурсов между модулями, чтобы сбой в одном месте не «тянул вниз» всю систему.

Chaos engineering проверяет, что эти паттерны действительно работают, а не просто задекларированы в документации. Эксперименты имитируют реальные сбои и показывают, где защита срабатывает, а где нужно добавить дополнительный предохранитель.

CNews: Что такое «blast radius» (зона воздействия эксперимента) и как сделать так, чтобы тесты не «уронили» всю систему?

Томас Хелльстром: Blast radius — это зона воздействия хаос-эксперимента. Проще говоря, это часть системы, которую вы «ломаете», чтобы проверить устойчивость.

- Если радиус слишком большой, эксперимент может вызвать массовый сбой: упадёт несколько сервисов сразу, клиенты увидят ошибки, бизнес понесёт потери.

- Если радиус слишком маленький, вы не проверяете реальные риски, а тест становится бесполезным.

На практике важно начинать с минимального радиуса: один контейнер, один сервис, тестовая среда. Когда команда уверена, радиус постепенно расширяют — например, до ограниченного процента продакшен-трафика.

Такой подход позволяет учиться на сбоях без риска остановить всю систему, постепенно наращивая уверенность в её устойчивости.

CNews: Как правильно настроить мониторинг и оповещения, чтобы понимать: это наш эксперимент или реальная авария? Какие метрики самые важные?

Томас Хелльстром: Перед запуском хаос-эксперимента важно предупредить команду и инженеров SRE: чтобы никто случайно не принял тест за настоящий сбой.

Каждый тест должен оставлять «след»:событие в логах, аннотацию на дашборде, отдельный тег или метку, по которой легко понять, что это эксперимент.

Ключевые метрики включают стандартные показатели SRE:

- латентность (время отклика сервисов);

- ошибки;

- трафик;

- использование ресурсов.

Но важно также следить за бизнес-показателями: количество успешных платежей, передача данных, успешные бронирования — иначе сбой может остаться незамеченным на уровне бизнеса.

Во время эксперимента регистрируется состояние системы до, во время и после теста. Любые расхождения с ожиданиями фиксируются как новые задачи по улучшению системы — это основной результат хаос-эксперимента.

CNews: Вы продвигаете TDD и увеличили покрытие тестами, сократив баги в продакшене. Как TDD сочетается с chaos engineering для повышения надёжности систем?

Томас Хелльстром: TDD (Test-Driven Development) защищает бизнес-логику: если тест зелёный, значит, модуль работает так, как задумано. Но TDD проверяет систему в «идеальных условиях» — когда все сервисы отвечают, сеть стабильна, данные корректны.

Chaos engineering проверяет систему в реальной жизни: что происходит при падении узлов, перегрузке сети или сбоях внешних сервисов.

Вместе они создают двойной барьер:

- TDD ловит логические ошибки на уровне кода;

- Chaos engineering выявляет непредвиденные сбои в инфраструктуре.

Результат: меньше багов, меньше неожиданных аварий и более устойчивая система.

CNews: Как облачные платформы AWS, GCP, Azure влияют на подходы к тестированию отказоустойчивости? Какие новые возможности они открывают?

Томас Хелльстром: Раньше инженерам приходилось вручную останавливать серверы или эмулировать сбои. Сегодня AWS, GCP и Azure предлагают управляемые инструменты — AWS Fault Injection Simulator, Azure Chaos Studio и Google DiRT — которые позволяют безопасно проводить хаос-тесты в продакшене, ограничивая радиус воздействия и наблюдая результаты в реальном времени.

С их помощью можно отключать узлы или целые зоны доступности, замедлять сеть, проверять работу резервирования, масштабирования и авто-восстановления. Главное преимущество — такие инструменты позволяют с лёгкостью создавать точечные и воспроизводимые сбои в сложной облачной инфраструктуре через простые настройки. Ещё один плюс — всё выполняется через инфраструктуру как код, что снижает ручной труд и повышает предсказуемость тестов.

Облака дают возможность наблюдать, как система ведёт себя под нагрузкой и при сбоях, выявлять узкие места и улучшать архитектуру задолго до того, как произойдёт реальная авария.

CNews: Как внедрить культуру «сбои — это нормально» в компании, где привыкли всё держать под контролем? С каким сопротивлением обычно сталкиваются команды?

Томас Хелльстром: Сопротивление обычно связано со страхом. Команды думают: «мы потеряем контроль» или «и так слишком много проблем». Эти опасения понятны, особенно в больших компаниях с высокой ответственностью за сервис.

Решение — идти маленькими шагами. Первый — честно признать: сбои всё равно будут происходить, даже в идеально управляемой среде. Chaos engineering помогает перевести этот хаос в управляемую плоскость: мы сами выбираем, когда и где «ломать» систему, и учимся реагировать на ошибки спокойно, без стресса и паники.

Начните с тестовой среды, потом переходите к ограниченным экспериментам в продакшене, например, затрагивая небольшой процент пользователей.

На практике такой подход снимает страх: команда видит реальную пользу. Ошибки больше не пугают, а становятся источником знаний, показывают слабые места системы и дают возможность заранее их исправить.

Я объясняю через простые, наглядные аналогии. Обычные тесты проверяют машину на ровной дороге, а хаос — на льду или в дождь. На сессиях я моделирую реальные сбои и задаю участникам практическую задачу: «Представьте, база данных упала, что делать?»

Главные элементы обучения включают:

- Разбор вариантов реакции — какие механизмы защиты срабатывают, где слабые места.

- Наглядные аналоги — сравнение с дорожными условиями, погодой, управлением машинами.

- Закрепление знаний через опыт — junior-разработчики видят, зачем нужны таймауты, retries и circuit breakers, и учатся действовать без паники.

Такой опыт закрепляет ценность подхода гораздо лучше, чем теория.

CNews: Какую роль играет машинное обучение в chaos engineering? Может ли ИИ предсказывать и предотвращать сбои?

Томас Хелльстром: Сегодня ИИ помогает анализировать инциденты и находить скрытые закономерности, которые человеку заметить сложно. Например, алгоритмы могут показать, что определённые комбинации нагрузки и сетевых задержек чаще приводят к сбоям.

В будущем ИИ сможет запускать хаос-эксперименты целенаправленно, там, где риск отказа системы выше всего, а не «наугад». Кроме того, машинное обучение помогает системам автоматически отличать сбой от нормы и реагировать в реальном времени.

Chaos engineering здесь играет роль «учителя»: мы создаём сбой, система учится на этих данных и постепенно становится более проактивной и устойчивой. Это шаг к тому, чтобы аварии можно было предсказывать и предотвращать до того, как они повлияют на пользователей.

Поделиться

Поделиться